¿La reputación ya no se busca?

(y por qué este cambio obliga a repensar la autoridad en la era de los motores de respuesta)

Hubo una época —no tan lejana— en la que gestionar reputación digital era, en esencia, un trabajo de encontrabilidad. Si alguien quería saber quién eras, qué hacía tu organización o qué tan confiable resultabas, la ruta era bastante predecible: abrir un buscador, leer titulares, visitar enlaces, contrastar versiones. La reputación se encontraba al final de un recorrido.

Esa lógica empezó a romperse sin estruendo. No porque la gente dejara de buscar, sino porque la respuesta empezó a llegar antes que la exploración.

Hoy, cuando un periodista prepara una nota, un cliente B2B evalúa proveedores o un comité directivo revisa riesgos, la pregunta inicial suele ser la misma de siempre: “¿Quién es X?” “¿Qué se sabe de Y?” “¿Qué tan confiable es Z?” La diferencia es la interfaz: cada vez más, lo primero que aparece no es una lista de enlaces, sino una respuesta sintetizada. Un resumen que trae “lo esencial”, atribuye fuentes, ordena el relato y entrega una conclusión práctica en segundos.

Ese fenómeno tiene una frase simple que lo describe: la reputación ya no se busca, se responde.

La reputación ya no se busca, se responde. ¿Qué significa el título de este artículo?

Cuando digo “se responde”, no estoy afirmando que nadie busque ni que el buscador haya perdido relevancia. Estoy describiendo un cambio específico en la toma de decisión:

- Antes: La reputación online se encontraba en una lista de resultados (SERP) que te daba Google , por ejemplo.

- Ahora (cada vez más): La reputación aparece como una respuesta sintetizada (sea en Google, Chat GPT, Grok, Perplexity depende donde busquemos los humanos la respuesta) (un “snapshot”) que resume “lo importante” antes del clic y, en ocasiones, sin clic.

Este giro está materializado en productos concretos:

- Google comunicó el despliegue de AI Overviews en EE. UU. desde el 14 de mayo de 2024.

- Microsoft presentó Copilot Search (Bing) el 4 de abril de 2025 como una experiencia que entrega resúmenes, respuestas claras o layouts inteligentes según la consulta.

- Perplexity se define como answer engine y documenta su enfoque de búsqueda con fuentes y síntesis conversacional. blumdigitalpr.com+1

Traducción para DIRCOM y consultores: una parte de la reputación se juega en el output (la respuesta que generan esos modelos) y no únicamente en el contenido fuente (tu web, notas, perfiles, Wikipedia, etc.). De esto me di cuenta desde el 2023, donde al preguntarle a chat GPT, sabía un poco sobre mí, pero Perplexity me citaba con admiración, mientras que para Gemini simplemente no existía y la gran duda asaltó mi mente: ¿Qué pasa si el scouting de una universidad me busca en Gemini o Chat GPT para saber si me contratan para un seminario o cátedra y no hay nada? Es culpa del Prompting? A los comunicadores no nos han entrenado para promptear

¿Cuántas oportunidades habré perdido?

Lectura base (para profundizar el concepto): Autoridad algorítmicahttps://soniayanez.com/autoridad-algoritmica-guia-completa/

El inicio del concepto: de reputación en SERP a reputación en outputs

En la era SERP, el trabajo reputacional digital se apoyaba en tres palancas principales:

- Cobertura (medios)

- Visibilidad (SEO, presencia, ranking)

- Monitoreo (clipping, alertas, social listening)

Eso sigue existiendo. Pero el motor de respuesta agrega una cuarta palanca que cambia el tablero:

-

Síntesis (el sistema decide qué es “lo esencial”, qué cita y qué omite)

Esa síntesis no es un detalle técnico. Es un acto editorial. Y en reputación, lo editorial siempre importa porque define, de forma inmediata:

- Inclusión u omisión: apareces o no apareces.

- Rol asignado: cómo te etiqueta (experta, empresa, controversia, “referencia secundaria”).

- Atribución: qué fuentes te legitiman (y cuáles no).

- Marco: el contexto que te favorece o te limita.

Por eso la reputación “se responde”: porque el sistema no solo muestra información; compone una narrativa breve y utilizable.

Aquí es donde se vuelve peligroso seguir mirando únicamente el ranking y el clipping como si fueran el “tablero completo”. El tablero cambió: ahora también hay que observar cómo se nos resume.

Mis primeros pasos: el momento en que la fricción se volvió pregunta de investigación

Mi interés por este fenómeno no nació del entusiasmo por la IA. Nació de una fricción profesional repetida: ver cómo trayectorias verificables y expertise real podían aparecer en outputs conversacionales de forma errática, incompleta o directamente omitida, mientras otros actores —menos sólidos, pero más “citables” o más presentes en ciertos tipos de fuentes— se instalaban con facilidad en respuestas rápidas.

Esa fricción se convirtió en pregunta:

¿Qué determina que un motor de respuesta te considere legítimo y te use como base para sintetizar?

En mi trabajo académico lo formulé así: los sistemas de IA conversacional no solo indexan y organizan; también sintetizan, interpretan y presentan conocimiento, amplificando o invisibilizando actores del ecosistema comunicacional.

Ese cambio —de índice a síntesis— es el punto de partida de este blog.

Y fue lo que, en 2025, me llevó a defender la discusión en espacios académicos: en IACOM (Astorga, 25–26 sept 2025) y en CINCOMA (Alicante, 26 sept 2025) la mirada hacia un nuevo ecosistema profesional: las RR.PP: 6.0. Aquí pueden leer más.

Qué aporta la evidencia externa: no es “sensación”, es un fenómeno observado

Para sostener este argumento con rigor, no alcanza con describir productos. También hay que mirar evidencia sobre cómo operan estos sistemas y qué riesgos conllevan.

- Ofcom publicó el discussion paper “The Era of Answer Engines” (noviembre 2025), donde describe cómo las herramientas de búsqueda con GenAI están cambiando el acceso a información hacia respuestas directas en lenguaje natural y discute implicaciones de seguridad y competencia. www.ofcom.org.uk+1

- Un estudio de auditoría en arXiv analizó respuestas de ChatGPT, Bing Chat y Perplexity, encontrando sesgos (sentimiento, geografía, tipo de fuentes) y variabilidad en la calidad de soporte. arXiv

- Reuters reportó un estudio (EBU + BBC) con 3.000 respuestas en 14 idiomas: 45% contenían al menos un error importante y 81% presentaban algún tipo de problema; además, los errores de atribución/fuentes fueron frecuentes. Reuters+1

Todo esto apunta a una conclusión prudente (y muy útil para comunicación): los motores de respuesta no solo son “nuevos canales”; son nuevos mediadores. Y, como mediadores, pueden acertar… o equivocarse con apariencia de autoridad.

No cito esto para alarmar. Lo cito para justificar un estándar: si la reputación se responde, el rigor ya no es opcional.

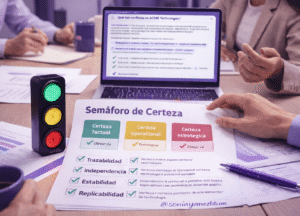

Semáforo de Certeza: certeza de qué y cómo se construye

Aquí aparece una pieza fundacional del enfoque de este blog: el Semáforo de Certeza.

No mide opiniones. Mide el estatus de una afirmación que puede afectar la reputación si se repite en comité, en prensa o en un output algorítmico.

Certeza de qué (tres niveles)

- Certeza factual: ¿es un hecho verificable?

- Certeza operacional: ¿puedo observarlo de forma replicable (mismo query, mismo patrón)?

- Certeza estratégica: ¿es una tendencia plausible, pero dependiente de contexto (país, industria, plataforma)?

Esta distinción es esencial porque evita dos errores comunes:

- convertir hipótesis en “verdades” por repetición,

- y tomar decisiones reputacionales basadas en frases impactantes pero no verificables.

Cómo se construye (cuatro pruebas simples)

Clasifico cada claim con cuatro pruebas:

- Trazabilidad: ¿hay fuente primaria o documento verificable?

- Independencia: ¿lo sostienen al menos dos fuentes confiables o una primaria robusta?

- Estabilidad: ¿cambia por UI/modelo o se sostiene en el tiempo?

- Replicabilidad: ¿otra persona puede repetir el procedimiento y observar algo similar?

Y entonces:

- 🟢 Verde (alto): trazable + suficientemente estable + replicable

- 🟡 Amarillo (medio): plausible, pero condicionado (requiere medición local)

- 🔴 Rojo (bajo): no trazable / demasiado variable / absolutista → se reformula o se elimina

Por qué este enfoque nació también en comunidad: la Maratón de las RRPP y el trabajo desde Blum Digital PR

Este tema no apareció “de golpe” en 2025. Se venía incubando en la práctica, especialmente en conversaciones con profesionales que sentían la misma tensión: ¿cómo se protege la reputación cuando el primer contacto ya no es un enlace, sino una síntesis?

Por eso creé espacios de conversación aplicada con visión regional. Un ejemplo es la Maratón Internacional de las RR.PP. 6.0, un formato que se ha consolidado por ediciones; en tu propia comunicación pública se la presenta como una iniciativa sostenida (cuarta edición) y como un espacio donde se discuten reputación algorítmica, crisis, KPIs y ética en IA. LinkedIn+1

Y desde Blum Digital PR —mi firma— este enfoque se traduce en práctica: investigación + consultoría + formación aplicada en reputación, IA y relaciones públicas digitales.

Blum Digital PR: https://blumdigitalpr.com/ blumdigitalpr.com

(Este artículo no pretende narrar toda esa historia: solo dejar claro que el concepto “se responde” nace de una combinación de observación sistemática, discusión profesional y formalización académica.)

Decir que la reputación ya no se busca: se responde significa esto:

Parte de la reputación dejó de ser únicamente un problema de encontrabilidad (SERP) y pasó a ser también un problema de representación (output): qué resumen aparece, con qué fuentes, con qué tono y con qué omisiones.

Y si eso es cierto —con certeza verde para los hechos y amarilla para lo contextual— entonces el trabajo reputacional moderno empieza por una disciplina básica: no repetir afirmaciones sin clasificar su certeza, y no tomar decisiones estratégicas sin entender cómo el sistema “edita” tu narrativa.

Te invito leer estos otros recursos para que estés al día:

-

Ofcom – The Era of Answer Engines (PDF):

https://www.ofcom.org.uk/siteassets/resources/documents/research-and-data/online-research/other/the-era-of-answer-engines---discussion-paper.pdf?v=407139www.ofcom.org.uk -

Li & Sinnamon (2024) – Generative AI Search Engines as Arbiters of Public Knowledge (arXiv):

https://arxiv.org/abs/2405.14034arXiv -

EBU (2025) – estudio sobre distorsión sistémica de noticias por asistentes IA:

https://www.ebu.ch/news/2025/10/ai-s-systemic-distortion-of-news-is-consistent-across-languages-and-territories-international-study-by-public-service-broadcasteebu.ch -

Reuters (2025) – cobertura del estudio EBU/BBC (contexto ejecutivo):

https://www.reuters.com/business/media-telecom/ai-assistants-make-widespread-errors-about-news-new-research-shows-2025-10-21/Reuters